NN07 - Training & Testing

Kurze Übersicht

Training und Testing

-

Der tatsächliche Erfolg eines Modells wird nicht durch niedrige Trainingskosten gemessen, sondern durch geringe Kosten auf ungesehenen Daten, d.h. hohe Vorhersagekraft, gute Generalisierung!

-

Die Menge aller gelabelten Daten in Trainingsset und Testset aufteilen, Testset nicht während des Trainings einsetzen!.

Analogie:

-

Die Näherung

- Das Testset sollte genug Daten enthalten. Üblicher Anteil an Testdaten:

- bei

- bei

- Beispiel: Hat man 1000 Beispiele im Testset, wird

- bei

- Trainingsdaten und Testdaten sollten möglichst aus derselben Verteilung kommen, wie die zukünftigen Real-World-Daten.

- Das Testset sollte genug Daten enthalten. Üblicher Anteil an Testdaten:

-

Wichtige Bemerkung:

- Testdaten nicht anfassen, bis das Modell Einsatzbereit ist!

- Die Testdaten dürfen in keinster Weise bei der Auswahl der endgültigen Hypothese eingesetzt werden, weder bei der Berechnung der Parameter (Training), noch bei der Bestimmung der Hyperparameter (Hyperparameter-Tuning).

- Sobald der Testfehler die Auswahl der endgültigen Hypothese beeinflusst, kann sie nicht mehr als "Gütesiegel" eingesetzt werden.

CHECK: Hätte man zufällig andere Testdaten gewählt, könnte sich dadurch die endgültige Hypothese ändern?

Validierung und Modellauswahl

-

Das Ziel ist es, das Modell mit bester Generalisierung, also kleinstem

-

LÖSUNG: Einen weiteren Teil der Daten als Validierungsset (auch development set) beiseitelegen und nicht für das Training (i.e. Minimierung des Trainingsfehlers

-

Bemerkung:

Das Wort Modell kann je nach Kontext unterschiedliche Bedeutungen annehmen.

Ein Modell im aktuellen Kontext ist als ein Paar- Die Auswahl eines Modells kann aus einer Menge von Modellen unterschiedlicher Art erfolgen (z.B. lineare Modelle, polynomiale Modelle, neuronale Netze), oder von Modellen derselben Art aber mit unterschiedlichen Hyperparametern (z.B. Neuronale Netze mit unterschiedlicher Anzahl von versteckten Schichten).

- Außerdem kann dieselbe Modellarchitektur

-

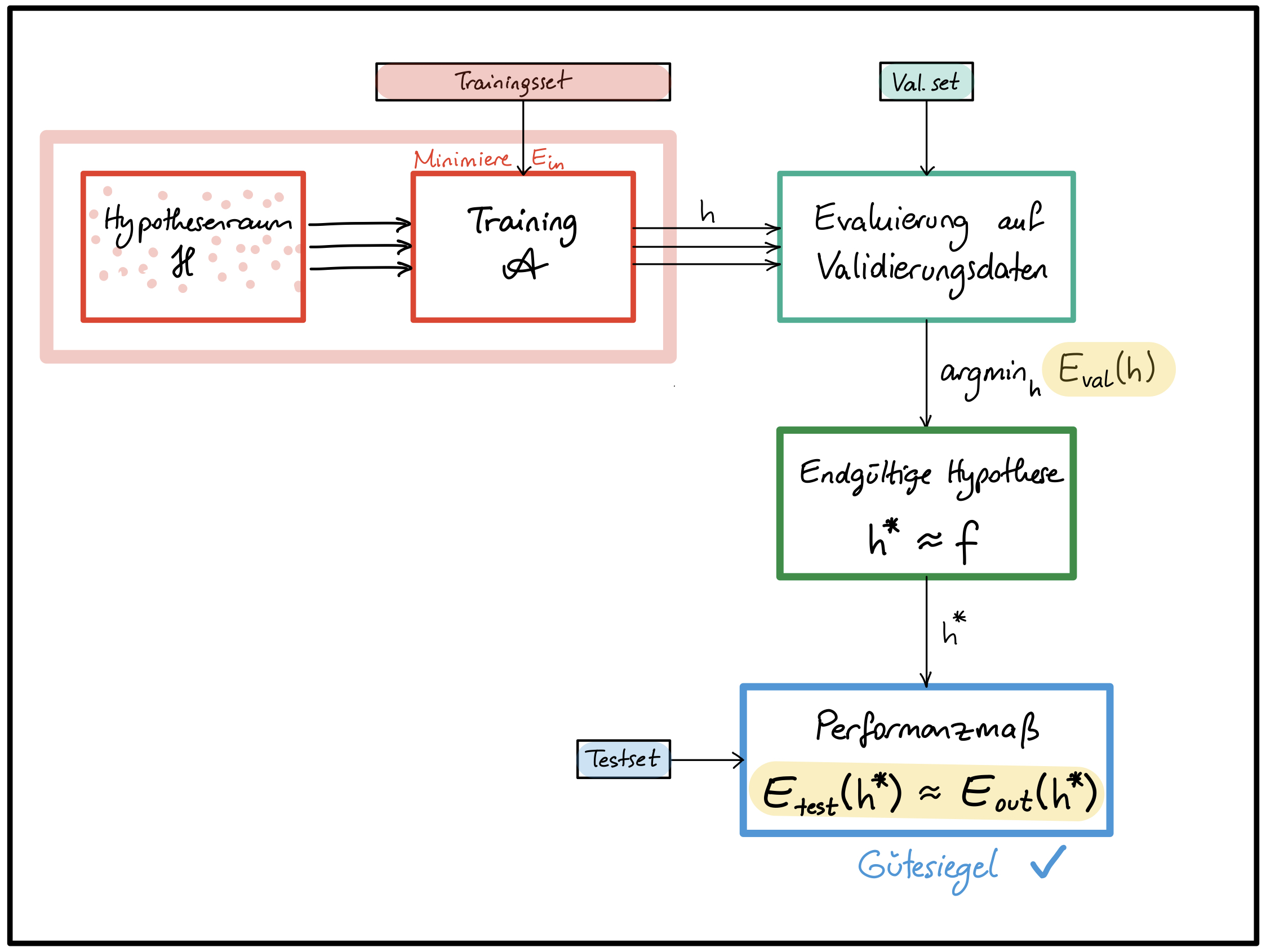

Der Validierungsfehler

- Bei der Auswahl geeigneter Hyperparameter wie z.B. Anzahl Schichten, Anzahl Zellen/Schicht, Aktivierungsfunktion, Regularisierungsparameter (siehe Abbildung 1).

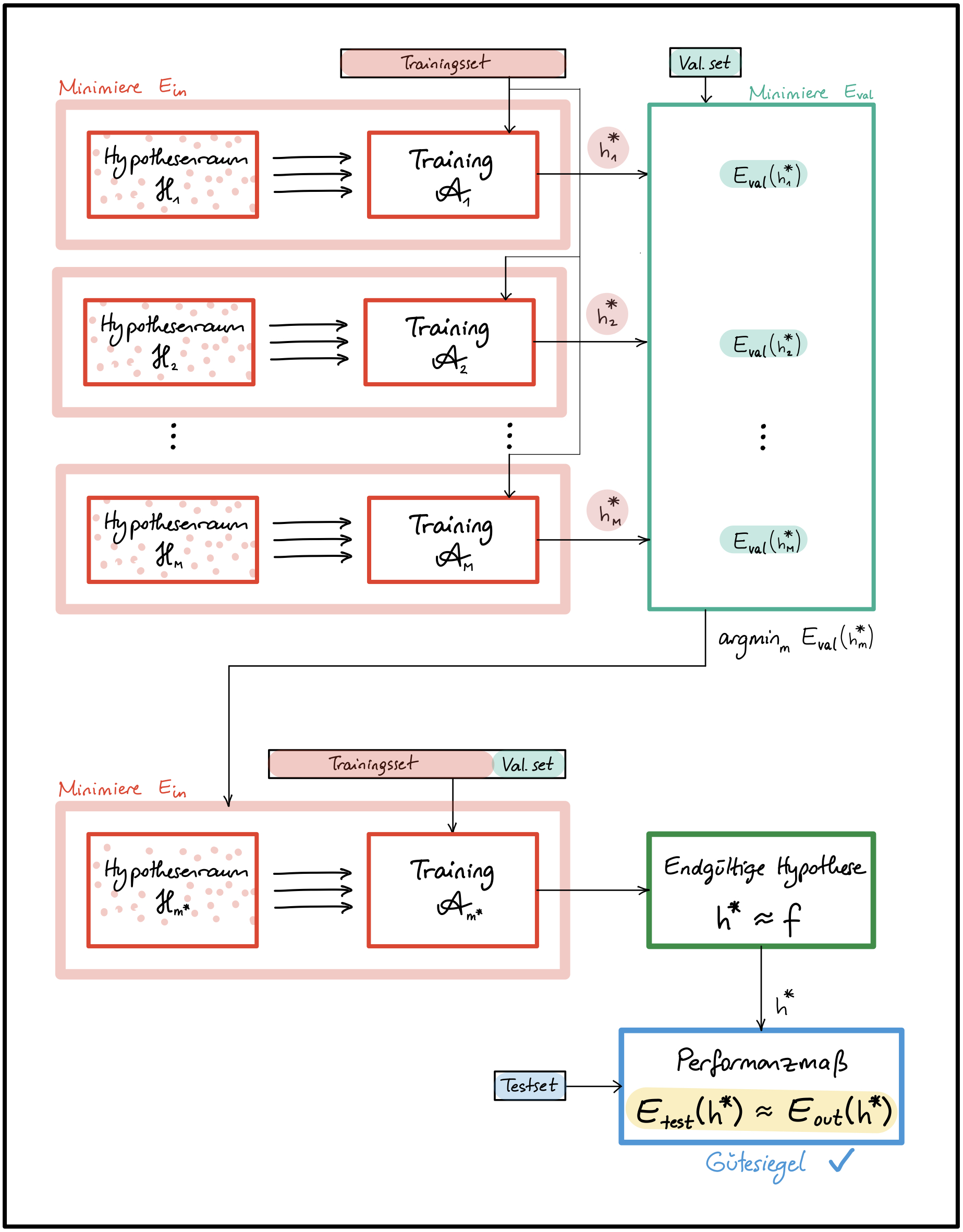

Abbildung 1 - Einsatz der Validierung für das Hyperparameter-Tuning

- Bei der Auswahl der endgültigen Hypothese (

Abbildung 2 - Einsatz der Validierung bei der Auswahl der entgültigen Hypothese

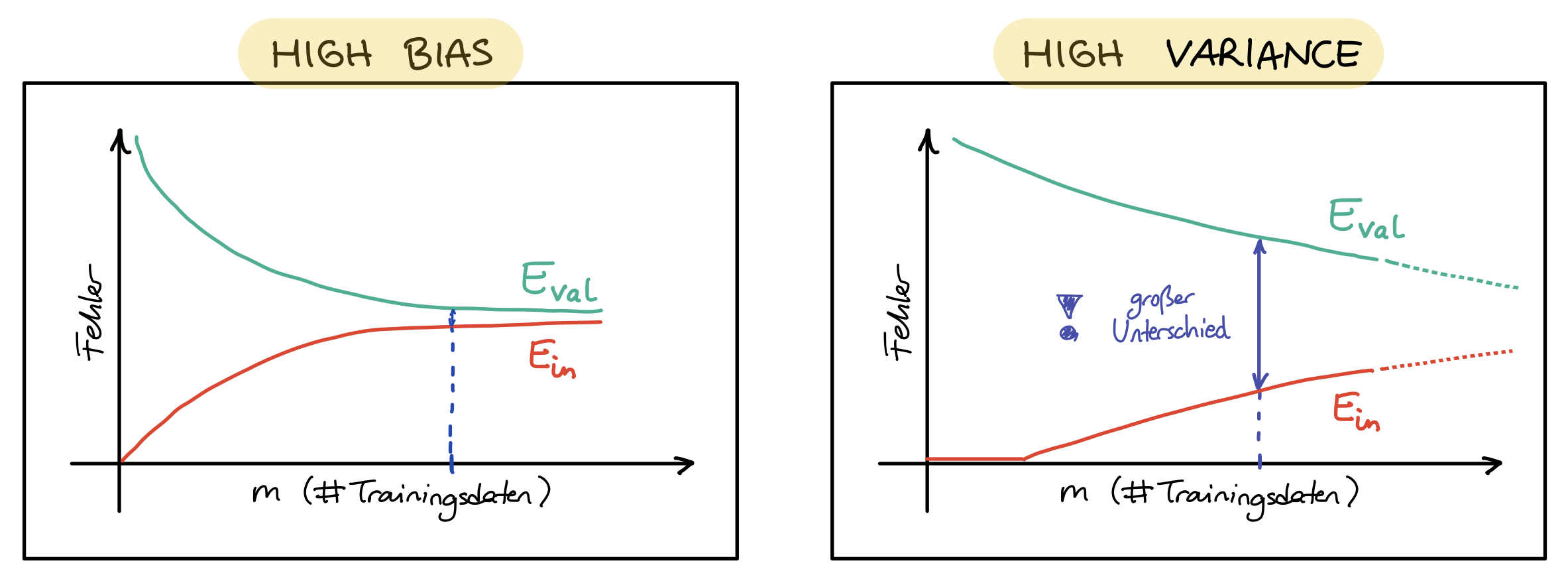

- Bei der graphischen Darstellung von Lernkurven für die Diagnose von Über- und Unteranpassung (siehe Abbildung 3).

Abbildung 3 - Lernkurven

-

Übliche train/val/test Aufteilung der Daten (in Prozent):

- bei

- bei

- bei

-

Bemerkung:

Das Modell ist trainiert für gute Ergebnisse auf Trainingsdaten und "fine-tuned" für gute Ergebnisse auf den Validierungsdaten. Ergebnisse auf Testdaten werden mit hoher wahrscheinlichkeit schlechter ausfallen, als auf Validierungsdaten ( -

Sind Validierungs- und/oder Trainingsset zu klein, führt das zu schlechten Näherungen

- Bei der Aufteilung muss ein gutes Trade-off gefunden werden.

- Wenn kein Gütesiegel notwendig ist, kann man auf das Testset verzichten und die Daten in Trainings- und Validierungsset aufteilen.

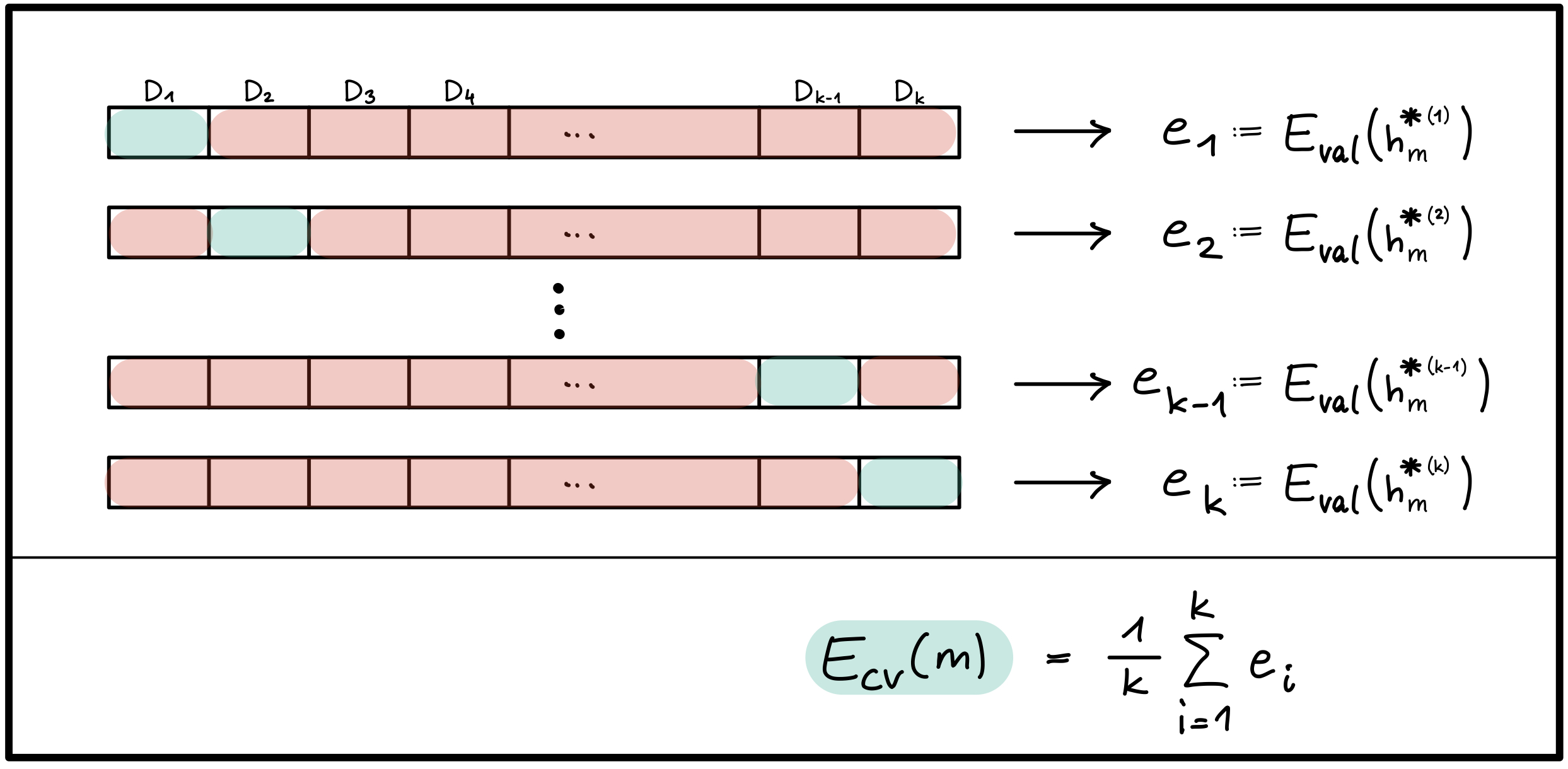

- Für eine bessere Näherung mit weniger Validierungsdaten kann k-fache Kreuzvalidierung eingesetzt werden (wenn genug Rechenkapazität vorhanden ist).

K-fache Kreuzvalidierung (engl. k-fold cross-validation):

-

Das Modell

-

Die Trainingsdaten werden in

-

Bei dem

-

Der Kreuzvalidierungsfehler des Modells

Abbildung 4 - Kreuzvalidierung

-

-

Bemerkung: Die Kreuzvalidierung wird nur bei der Modellauswahl eingesetzt: es liefert verlässlichere Näherungen für

- (K2) Trainings-, Validierungs- und Testfehler

- (K2) Zweck einer Testmenge

- (K2) Kreuzvalidierung

- (K2) Hyperparameter-Tuning

- (K2) Lernkurven

- [AbuMostafa2012] Learning From Data

Abu-Mostafa, Y. S. und Magdon-Ismail, M. und Lin, H., AMLBook, 2012. ISBN 978-1-6004-9006-4.